结构为王 构建高效数据分析方法论与实践指南

在数据驱动的时代,数据分析不再仅是技术手段,更是企业决策与创新的核心驱动力。面对海量、异构的数据,许多分析项目却因缺乏系统性的方法论而陷入混乱。本文旨在探讨如何以“结构为王”的理念,构建清晰、高效的数据分析方法论,并结合CSDN博客的实践经验,介绍数据处理服务的核心要素与最佳实践。

一、数据分析方法论:构建结构化思维框架

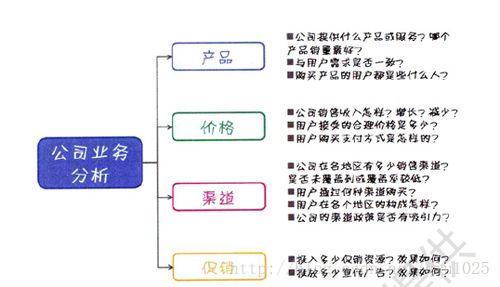

数据分析的成功始于一个坚实的结构化方法论。一个完整的数据分析流程通常包含以下核心环节:

- 目标定义与问题拆解:明确分析目标,将复杂业务问题拆解为可量化、可分析的具体问题。这是所有分析的起点,确保后续工作不偏离方向。

- 数据收集与评估:根据问题确定所需数据源,评估数据的可用性、质量(完整性、准确性、一致性)和获取成本。

- 数据清洗与预处理:这是数据处理服务的核心,包括处理缺失值、异常值、重复数据,进行格式标准化、数据转换等,为分析提供“干净”的数据基础。

- 数据探索与分析建模:运用描述性统计、可视化探索数据特征,并选择合适的模型(如统计分析、机器学习模型)进行深入分析,发现模式、关联与洞察。

- 结果解读与可视化呈现:将分析结果转化为易于理解的业务语言,通过图表、仪表板等形式清晰呈现,支撑决策。

- 部署、监控与迭代:将分析成果融入业务流程,并持续监控效果,根据反馈进行迭代优化。

结构化方法论的价值在于,它提供了可重复、可验证的路径,减少了随意性,提升了分析效率与结果的可靠性。

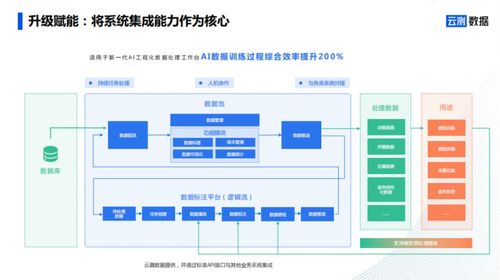

二、数据处理服务:方法论落地的工程基石

数据处理是方法论中承上启下的关键环节,高质量的数据处理服务是产出可靠洞察的保障。其核心服务通常包括:

- 数据集成:从数据库、API、日志文件、第三方平台(如CSDN博客后台)等多源异构数据中抽取、整合数据。

- 数据清洗:自动化或半自动化地检测并修复数据中的错误、不一致和缺失。

- 数据转换与规约:进行数据聚合、特征工程、维度转换等,将原始数据转化为适合分析的格式。

- 数据存储与管理:设计高效的数据存储方案(如数据仓库、数据湖),确保数据的安全性、可访问性和可管理性。

以分析CSDN博客运营效果为例,数据处理服务需要整合博客访问日志、用户互动数据(评论、点赞)、内容元数据等,清洗掉爬虫流量、统一时间格式、构建用户行为序列特征,最终形成可供分析的结构化数据集。

三、实践融合:以CSDN博客数据分析为例

将结构化方法论与数据处理服务结合,可以系统化地解决实际问题。例如,为提升CSDN博客的影响力,我们可以进行如下分析:

- 目标定义:未来三个月内,将某技术专栏的平均阅读量提升20%。

- 数据收集:通过CSDN开放API或后台导出,获取历史博客的标题、标签、发布时间、阅读量、点赞、收藏、评论等数据。

- 数据处理:清洗异常发布时间记录;将“标签”字段进行拆分和标准化;计算“互动率”(点赞+收藏+评论)/阅读量等衍生指标。

- 分析与建模:

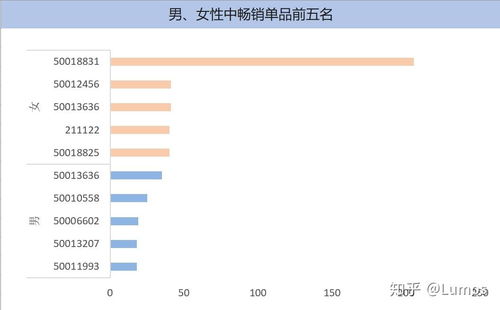

- 探索性分析:哪些标签的博客平均阅读量更高?发布在什么时间段(如工作日/周末,上午/下午)的博客更容易获得初始流量?

- 关联分析:标题长度、是否含有关键词与阅读量是否存在相关性?

- 构建预测模型:基于历史数据,尝试预测新发布博客的潜在热度。

- 洞察与行动:

- 发现:带有“实战”、“源码解析”标签、在周二下午发布的博客平均互动率更高。

- 建议:优化内容标签策略;调整发布时间计划;针对高互动率主题进行系列创作。

- 迭代:实施建议后,持续监控新博客数据,评估效果并调整策略。

四、

“结构为王”强调的是一种系统性的、工程化的思维。在数据分析中,它体现为从目标到落地的完整方法论闭环,以及支撑这一闭环的稳健、高效的数据处理服务。无论是个人博主分析内容效果,还是企业进行商业智能决策,遵循结构化的路径,夯实数据处理的基础,都能让数据真正释放其价值,驱动持续的增长与优化。从明确问题开始,用结构化的方法处理数据,最终用清晰的洞察指导行动,这正是数据时代致胜的关键。

如若转载,请注明出处:http://www.jumeiguang.com/product/59.html

更新时间:2026-02-24 15:46:55